BIツールのパフォーマンス低下を引き起こす要因

BIツール(Business Intelligence)は、ビジネスにおけるさまざまなデータを収集・分析・可視化し、ビジネス上の意思決定の迅速化を助けるツールです。機能として、主に「分析・可視化」を強みとしているのが特長です。

スピーディーな判断に貢献する一方、活用すればするほどデータ量が多くなり、複雑な集計などによりパフォーマンスが低下することもあります。どんなに有益なレポートを作っても、表示に時間がかかるため使われなくなってしまっては本末転倒です。

BIツールは主に以下の流れで処理を進めており、タイムリーにデータを可視化するためには高いパフォーマンスが求められます。

①多種多様なデータの収集

最初にデータを収集する過程では、販売管理システムやSFAなど、さまざまな業務システムからデータを集めます。

こうした膨大なデータ量をBIツールに取り込むことは、パフォーマンスの低下につながります。

②収集したデータの分析・加工

続くデータの分析では、膨大なデータをリアルタイムに分析してユーザーに結果を返すOLAP分析(オンライン分析処理)などを行います。

分析のパターンが複雑になるほど処理に時間がかかり、パフォーマンスの低下を招くことになります。

また、データの入力形式が揃っていないケースでは、専門知識のある担当者によるSQLなどでの事前の加工処理なども必要になり、スピーディーなレポーティング実現の足かせになることも。

③データのレポーティング

そしてデータのレポーティングとして、分析したデータをユーザーが見やすい形式で可視化します。

上記のようなプロセスを踏みながら膨大なデータを収集・分析・加工・可視化しているため、データ量や、見たいデータの期間・範囲によっては、BIツールに負荷がかかることでパフォーマンスが低下し、処理に時間がかかってしまうケースがあります。

BIツールのパフォーマンス向上のためにすぐに取り組める改善策

続いて、BIツールのパフォーマンス向上のためにすぐに取り組める改善策について、レポーティングにいたるまでのプロセスを3つに分けて解説します。

- データの収集

- データの分析・加工

- データの可視化

1.データの収集

まずは、データを収集する前に、BIツールでどのようなレポートを見たいのか十分に検討することが重要です。

レポーティングに必要な最低限のデータに絞ることで、必要のないデータまで取り込むことを防ぎ、負荷軽減につながります。

2.データの分析・加工

データの分析・加工に要する時間を確認し、時間がかかっている場合はSQLやビューの見直しを行います。例えば、処理ステップをまとめたり、不要な処理は削除したりすることが重要です。

また、製造現場にあるIoTデータなどは、直接BIツールに取り込んでも活用しづらいケースが多く、事前の処理が必要となります。

このような前処理ができていると、この後の「可視化」のプロセスがスムーズに進みます。

3.データの可視化

データの可視化では、BIツールが持つビジュアライゼーションの強みを損なうことなく、取り組める改善策がよいでしょう。

- レポートを複数開いている場合、必要最小限のレポートだけを残して他は閉じる

- 表示したいデータの検索期間を絞る

- 明細はすべてをレポートに表示させるのではなく、ドリルスルーで個別に確認する

なるべくシンプルな形式にすること、必要なレポートのみを参照することが有効です。

根本解決には「データ分析基盤」の活用がおすすめ

前述した改善策は、すぐに取り組める即効性や手軽さがある一方、根本的な解決にはつながりにくいといえます。なぜなら、BIツールの活用が進むほど、処理に時間がかかる複雑なSQL・ビュー、扱うデータ量などが増えてパフォーマンス低下につながるためです。

このような背景から、BIツールのパフォーマンス問題を「根本的に」解決したい場合は、「データ分析基盤」の活用が効果的です。

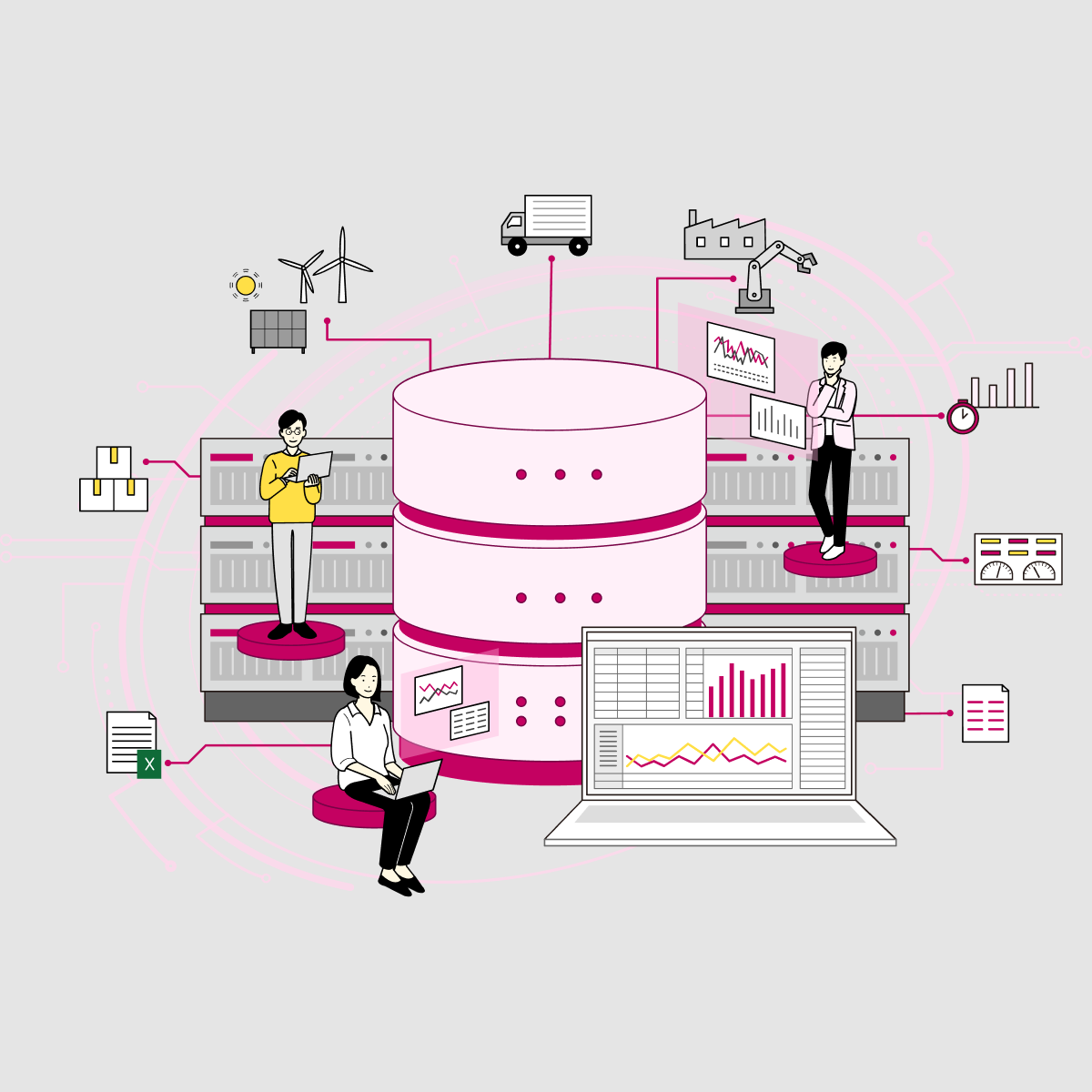

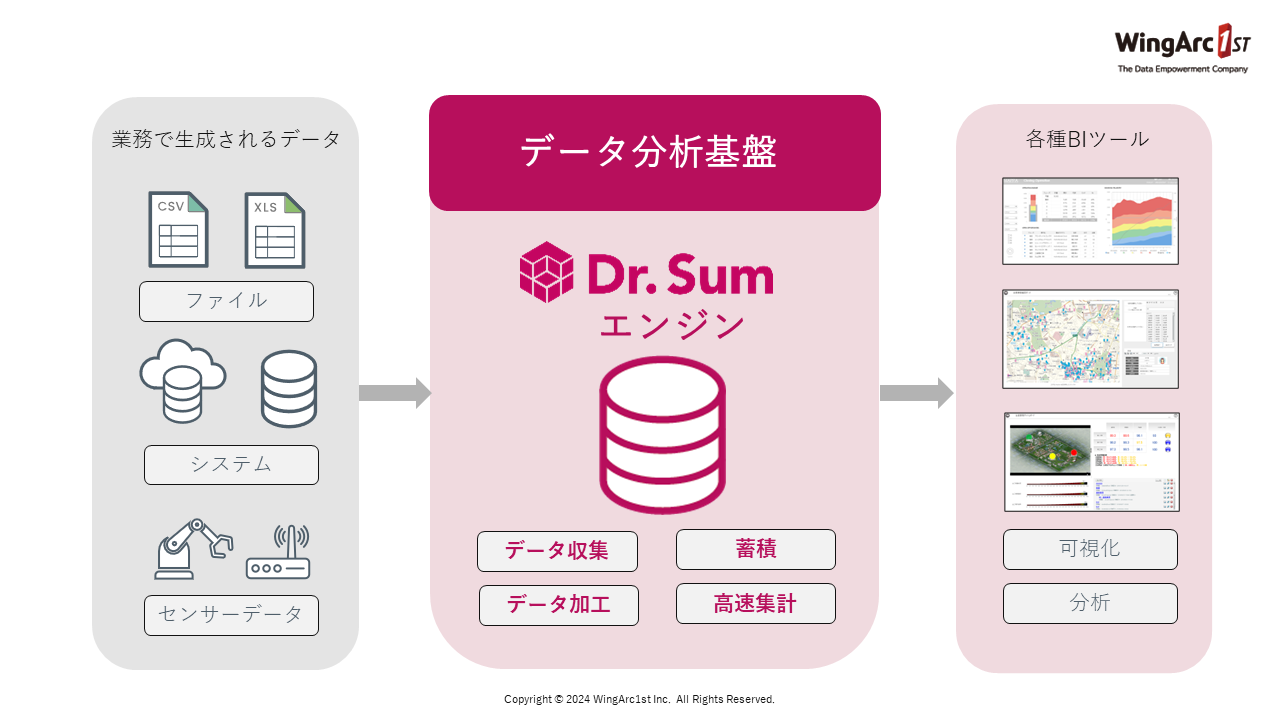

データ分析基盤とは、「分析に必要なデータを、活用しやすいキレイな状態に整えて集約した箱」のようなものです。

一般的にはデータベースというソフトウェアを使い構築します。

役割に応じて、データレイク、データウェアハウス、データマートなどと呼ばれたり、マーケティングに特化した用途においては「CDP:カスタマー・データ・プラットフォーム(Customer Data Platform)」という表現を用いたりなど様々な呼ばれ方をしますが、ここでは「分析に必要なデータを、活用しやすいキレイな状態に整えて集約した箱」という役割を担うものとして「データ分析基盤」と総称しています。

データ分析基盤を利用すれば、以下の理由で、BIツールでのスピーディーなビッグデータ分析が可能になります。

- データ連携ツールが備わっているため、BIツールが各データソースと直接繋ぐ必要がなくなり、BIツール自体の負荷を下げることができる

- 大量データを蓄積し集計できるデータベースが備わっているため、BIツールに表示させるためのデータを事前に集計しておくことができる

- 製造現場のセンサーデータ(IoTデータ)なども、あらかじめ事前集計しておくことでBIツールでのレポート表示速度の向上がはかれる

BIツールでもデータの収集や加工はできますが、大量データの処理能力に限界がありパフォーマンスに影響を及ぼすケースも少なくありません。

一方で、データ分析基盤であれば膨大なデータの収集や蓄積、加工、分析に特化した構造のため、高いパフォーマンスを維持しながら処理することが可能です。

したがって、大量データの収集・蓄積・加工などはデータ分析基盤で行いつつデータの可視化はBIツールで行うなど、適材適所の仕組みを構築することが重要となるでしょう。

ただし、データ分析基盤を活用する場合においても、費用や導入スケジュール、社内での運用継続などの課題は生じます。そのような課題を解消しながらデータ分析基盤を有効活用していく上では、「Dr.Sum」の活用がおすすめです。

はじめてのデータ分析基盤にはDr.Sum

ここまで、BIツールのパフォーマンス低下の要因、改善策、そして一般的なデータ分析基盤の概要について解説してきましたが、弊社のデータ分析基盤「Dr.Sum」の強みについてご紹介します。

ローコードで誰でも利用可能

一般的なデータ分析基盤の利用にあたっては、プログラミングや専門知識が必要です。

Dr.Sumではノーコード開発が可能であるため、構築・運用においてプログラミングの知識は必要ありません。

Dr.Sum内に必要な機能が揃っているため、基本的なデータベースについての理解があれば、ノンプログラミングで構築・運用ができ、情報システム部門のみならず各部門での利用が進みやすいというメリットがあります。

超高速なデータ処理エンジン搭載

10億件のデータを1秒で処理可能な超高速エンジンが搭載されており、BIツール上の処理速度を飛躍的に向上させます。

販売データなどデータの更新頻度が高く膨大なデータ量を取り扱うケースなどは、特にBIのパフォーマンスに大きく影響するため、高速集計・多重処理が可能で、ストレスなくデータ集計が可能な点はメリットになるでしょう。

多様なインターフェース

また、ユーザーインターフェースが提供されているため、スピーディーにDr.Sum上で分析結果を参照することができます。

さらに弊社製品のBIツール「MotionBoard」、およびPowerBIやTableauといったセルフBIツールとのシームレスな連携も可能です。

充実のサポート体制

マニュアルやTips集、学習コンテンツも充実しているため、社内に高度なスキルを持つIT人材が少ない企業でも問題なく導入することが可能です。

さらに手厚いサポート体制も整っており、保守継続率93.8%(2021年2月期実績、全製品平均値)と高い継続率を誇っている点も特徴的です。

まとめ

BIツールはデータドリブンな経営に役立つ反面、活用すればするほど、データ量の増加や見たいデータ範囲の拡大に伴ってパフォーマンスの低下が課題となりがちです。

膨大なデータを扱う場合や複雑な分析・加工を行う場合などは、処理に時間がかかってしまい、せっかく導入したはずのBIツールが活用されないといったケースも起きうるでしょう。

まずはすぐに対処できる改善策から取り組んでみるのがよいですが、いずれも一時的な対処になります。問題を根本的に解決するためには、データ分析基盤の活用が不可欠です。

Dr.Sumを活用することで、膨大なデータの収集や蓄積、加工、分析を行う際でも高いパフォーマンスを維持しながらの処理が可能になるため、充実したビジュアライゼーション、柔軟なレポーティングといったBIツールの良さを最大限に活かすことができます。

ご利用のBIツールのパフォーマンスに課題を感じられている方は、はじめてのデータ分析基盤としてDr.Sumという選択肢はいかがでしょうか?